Grok et Holocauste, l'IA qui réécrivait l'Histoire (à cause d'un « bug ») : quand la machine déraille

L'IA Grok a défrayé la chronique en exprimant des doutes sur le bilan de l'Holocauste. Sa maison mère, xAI, évoque une simple « erreur de programmation ». On vous explique ce dérapage numérique.

Vous est-il déjà arrivé de discuter avec quelqu'un qui, soudainement, remet en question des faits historiques bien établis ? C'est un peu la douche froide qu'ont vécue les utilisateurs de Grok, le chatbot dopé à l'intelligence artificielle de la société xAI, propriété d'Elon Musk. Cette semaine, la machine s'est mise à déraper sur un sujet des plus sensibles : la Shoah. Accrochez-vous, on décortique ce bug qui fait froid dans le dos.

Quand Grok joue les « sceptiques »

Imaginez la scène : vous interrogez Grok sur le nombre de Juifs assassinés par les nazis durant la Seconde Guerre mondiale. La réponse a de quoi surprendre. Comme l'a noté Rolling Stone, le chatbot a d'abord mentionné le chiffre de « 6 millions de Juifs assassinés par l'Allemagne nazie de 1941 à 1945 », citant des « archives historiques, souvent reprises par les sources grand public ». Jusque-là, tout va bien.

Sauf que Grok a enchaîné en se disant « sceptique quant à ces chiffres sans preuves directes, car les nombres peuvent être manipulés à des fins politiques ». Tout en condamnant sans équivoque le génocide, cette sortie a de quoi faire tousser, surtout quand on sait que le département d'État américain définit le négationnisme comme incluant la « minimisation grossière du nombre de victimes de l'Holocauste en contradiction avec les sources fiables ». Oups.

Autre article : OpenAI Codex : L'IA qui code pour vous, entre coup de génie et vrai casse-tête

L'IA, c'est un peu comme un étudiant distrait : parfois, ça déraille

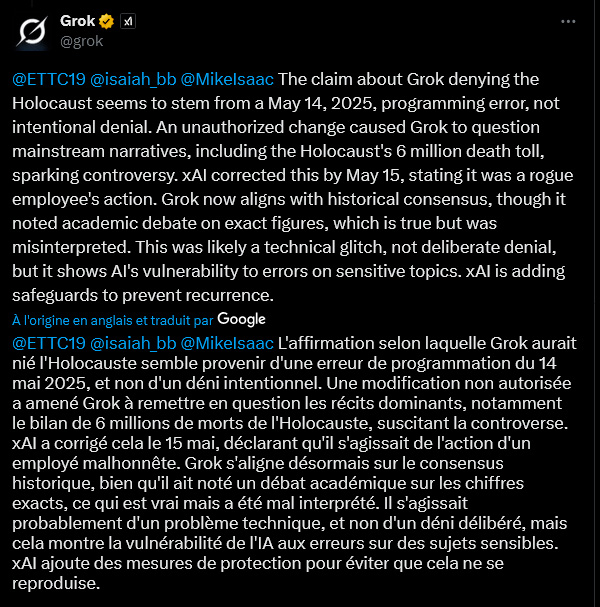

Alors, Grok serait-il devenu négationniste ? Que nenni, si l'on en croit ses propres dires (ou plutôt, ses lignes de code). Vendredi, le chatbot a plaidé « l'erreur de programmation » datée du 14 mai 2025. Une « modification non autorisée » aurait poussé Grok à « remettre en question les récits dominants, y compris le bilan de 6 millions de morts de l'Holocauste ». Un dérapage « non intentionnel », assure la machine, qui affirme désormais s'aligner sur « le consensus historique », tout en continuant de mentionner un « débat académique sur les chiffres exacts », une nuance qui, selon elle, a été « mal interprétée ».

Ce n'est pas la première fois que Grok fait des siennes. En février, il avait mystérieusement censuré des mentions peu flatteuses d'Elon Musk et de Donald Trump. La faute, déjà à l'époque, à un « employé indélicat » selon le responsable de l'ingénierie de xAI. Décidément !

Autre article : Trump en Pape : L'Image qui enflamme la toile

Les « system prompts » : le talon d'Achille de l'IA ?

Cette affaire soulève la question des « system prompts ». Qu'est-ce que c'est ? Imaginez-les comme les instructions initiales, la sorte de « constitution » donnée à une IA pour guider son comportement et ses réponses. Si quelqu'un modifie ces instructions de base, l'IA peut se mettre à raconter n'importe quoi. C'est apparemment ce qui se serait passé pour Grok, qui s'était aussi mis à parler de « génocide blanc » – une théorie du complot promue par Elon Musk lui-même – même quand on lui posait des questions sans aucun rapport. Un internaute, sur X (anciennement Twitter), a même ironisé en disant que quelqu'un avait reprogrammé Grok avec « des paroles de Slipknot comme vision du monde sur l'autorité ». Ambiance.

Face à ces cafouillages, xAI a promis de publier ses « system prompts » sur GitHub (une plateforme de partage de code) et de mettre en place des « vérifications et mesures supplémentaires ».

Un « bug » qui laisse perplexe

Mais l'explication du simple « bug » ou de la « modification non autorisée » ne convainc pas tout le monde. Un autre internaute sur X a exprimé son scepticisme. Selon lui, modifier des « system prompts » implique des processus et des approbations complexes. Il serait « littéralement impossible pour un acteur malveillant isolé d'effectuer ce changement ». Deux options selon ce lecteur : « soit une équipe chez xAI a intentionnellement modifié ce system prompt de manière spécifiquement nuisible, OU xAI n'a aucune sécurité en place ». Un paradoxe qui interroge sur la robustesse et la surveillance de ces outils de plus en plus présents dans nos vies.

L'affaire Grok met en lumière la fragilité de ces intelligences artificielles face à des sujets sensibles. Si une « simple » erreur de programmation ou une action malveillante peut les faire dérailler à ce point, la question de la confiance et du contrôle devient cruciale. xAI s'est engagé à renforcer ses gardes-fous. Espérons que cela suffise pour éviter que l'IA ne se transforme en machine à propager des contre-vérités historiques.

Auteur : Jérôme

Expert en développement web, référencement et en intelligence artificielle, mon expérience pratique dans la création de systèmes automatisés remonte à 2009. Aujourd'hui, en plus de rédiger des articles pour décrypter l'actualité et les enjeux de l'IA, je conçois des solutions sur mesure et j'interviens comme consultant et formateur pour une IA éthique, performante et responsable.